搜索到

289

篇与

的结果

-

群晖7.1.1版本媒体播放器方案 0x1 现状 升级到群晖7.1.1后,ds video没什么问题,但是不再像以前方便的安装解码器了,会影响一些视频的转码和音频,说简单点很多视频要么不能播放,要么播放没声音。 而根据网上的一些文档安装解码器,步骤:洗半白、安装破解AME、安装ffmpeg、安装破解解码。但是结果无效。 0x2 emby 折腾了许久仍然不行,那么不再使用ds video了,使用其他替换也是一样的,其中有 jellyfin,emby,plex。其中第一个是完全免费,是emby的开源版,后两个收费。这里选择 emby PS 一开始选择的群晖套件版本的 meby,但是实际测试手动刮削内容不出来,查看 emby 日志超时,及时群晖设置网络代理,所以最后更换为 docker 的方式安装 emby ,刚好也有提供好的快乐版,在 dockerhub 下载好镜像后,启动命令如下: docker run \ -p '8096:8096' \ -p '8920:8920' \ -p '1901:1900/udp' \ -p '7359:7359/udp' \ -v /volume2/docker/emby/config:/config \ -v /volume2/docker/emby/data:/data \ -v /volume2/video:/data/video \ -e TZ="Asia/Shanghai" \ --device /dev/dri:/dev/dri \ -e UID=0 \ -e GID=0 \ -e GIDLIST=0 \ --restart always \ -e HTTP_PROXY="http://192.168.0.10:8001" \ -e HTTPS_PROXY="http://192.168.0.10:8001" \ --name emby \ -d lovechen/embyserver:latest 其中 1900 貌似是 DLAN 端口,但是我本机被占用了,所以更换为 1901 了。目录方面基本上就创建好 config 和 data 即可。再就是本机的 视频 目录需要挂载上去,用于后续添加媒体库

群晖7.1.1版本媒体播放器方案 0x1 现状 升级到群晖7.1.1后,ds video没什么问题,但是不再像以前方便的安装解码器了,会影响一些视频的转码和音频,说简单点很多视频要么不能播放,要么播放没声音。 而根据网上的一些文档安装解码器,步骤:洗半白、安装破解AME、安装ffmpeg、安装破解解码。但是结果无效。 0x2 emby 折腾了许久仍然不行,那么不再使用ds video了,使用其他替换也是一样的,其中有 jellyfin,emby,plex。其中第一个是完全免费,是emby的开源版,后两个收费。这里选择 emby PS 一开始选择的群晖套件版本的 meby,但是实际测试手动刮削内容不出来,查看 emby 日志超时,及时群晖设置网络代理,所以最后更换为 docker 的方式安装 emby ,刚好也有提供好的快乐版,在 dockerhub 下载好镜像后,启动命令如下: docker run \ -p '8096:8096' \ -p '8920:8920' \ -p '1901:1900/udp' \ -p '7359:7359/udp' \ -v /volume2/docker/emby/config:/config \ -v /volume2/docker/emby/data:/data \ -v /volume2/video:/data/video \ -e TZ="Asia/Shanghai" \ --device /dev/dri:/dev/dri \ -e UID=0 \ -e GID=0 \ -e GIDLIST=0 \ --restart always \ -e HTTP_PROXY="http://192.168.0.10:8001" \ -e HTTPS_PROXY="http://192.168.0.10:8001" \ --name emby \ -d lovechen/embyserver:latest 其中 1900 貌似是 DLAN 端口,但是我本机被占用了,所以更换为 1901 了。目录方面基本上就创建好 config 和 data 即可。再就是本机的 视频 目录需要挂载上去,用于后续添加媒体库 -

j3455-itx升级到群晖7.1.1版本系统 0x1 升级方式 之前黑群晖的方法都是使用网上提供的引导,刻录后再安装系统。虽然看起来不麻烦,但是引导版本相当重要,需要跟你的硬件匹配,需要跟系统匹配。所以基本上你能安装什么系统,取决于人家提供的版本,相当有局限性。 NEW 现在通过arpl即可动态的编译引导,之后就可以启动成功,arpl是巴西的以为大佬开发,git地址如下: https://github.com/fbelavenuto/arpl 原版已经不怎么更新了,现在国内大神根据原版做了符合国情的版本 在线编译的版本如下: https://github.com/wjz304/Redpill_CustomBuild 手动构建的版本: https://github.com/wjz304/arpl-i18n 在后续的版本中,推荐还是使用手动构建的版本,这样需要填入的参数更少 使用repl构建引导 构建引导参考如下步骤: 前置配置,比如我的cpu是j3455,需要有一些特别的bios设置,还有bios针对linux的补丁,这些不论是使用什么引导都需要配置的 在git下载最新的镜像,解压得到img镜像 使用刻录工具把镜像刻录进入U盘,作为引导盘 接好所有的设备,群晖后续可能使用的,repl构建需要识别这些设备和接口,特别是硬盘、网线都要插好 U盘启动后选择配置,根据向导选择构建的机型、系统版本等信息。我j3455机器原来安装的ds918+ 6.2的系统,实际测试选择ds920+ 7.1.1没有问题。 选择构建后会自动下载引导程序并且构建为合适的引导,完成后会多一个重启到引导的选项 选择重启即可 接下来使用群晖的扫描工具,便可以在局域网找到机器 安装系统 找到机器后可以开始安装新版本系统了,下载新版本系统地址,根据系统版本下载: https://www.synology.cn/zh-cn/support/download 千万不要找到下面这个地址去了: https://archive.synology.com/download/Os/DSM/ 这个是引导的下载地址,不过下载后应该是不能安装成功的 PS. 最后出现的几个问题,记录: 选择镜像安装系统阶段,过了多个10分钟一直没有安装成功 需要把nas联网断开,可能是上传了镜像,但是仍然可能通过互联网下载某些安装包了,断开互联网,重启机器后重新选择安装速度正常 20240730 arpl 在github中拿掉了代码,并且没有更新了,但还是有一些小伙伴找到了最新资料的,试试根据下面文档升级到 7.2 版本吧 https://www.mspace.cc/archives/1002

j3455-itx升级到群晖7.1.1版本系统 0x1 升级方式 之前黑群晖的方法都是使用网上提供的引导,刻录后再安装系统。虽然看起来不麻烦,但是引导版本相当重要,需要跟你的硬件匹配,需要跟系统匹配。所以基本上你能安装什么系统,取决于人家提供的版本,相当有局限性。 NEW 现在通过arpl即可动态的编译引导,之后就可以启动成功,arpl是巴西的以为大佬开发,git地址如下: https://github.com/fbelavenuto/arpl 原版已经不怎么更新了,现在国内大神根据原版做了符合国情的版本 在线编译的版本如下: https://github.com/wjz304/Redpill_CustomBuild 手动构建的版本: https://github.com/wjz304/arpl-i18n 在后续的版本中,推荐还是使用手动构建的版本,这样需要填入的参数更少 使用repl构建引导 构建引导参考如下步骤: 前置配置,比如我的cpu是j3455,需要有一些特别的bios设置,还有bios针对linux的补丁,这些不论是使用什么引导都需要配置的 在git下载最新的镜像,解压得到img镜像 使用刻录工具把镜像刻录进入U盘,作为引导盘 接好所有的设备,群晖后续可能使用的,repl构建需要识别这些设备和接口,特别是硬盘、网线都要插好 U盘启动后选择配置,根据向导选择构建的机型、系统版本等信息。我j3455机器原来安装的ds918+ 6.2的系统,实际测试选择ds920+ 7.1.1没有问题。 选择构建后会自动下载引导程序并且构建为合适的引导,完成后会多一个重启到引导的选项 选择重启即可 接下来使用群晖的扫描工具,便可以在局域网找到机器 安装系统 找到机器后可以开始安装新版本系统了,下载新版本系统地址,根据系统版本下载: https://www.synology.cn/zh-cn/support/download 千万不要找到下面这个地址去了: https://archive.synology.com/download/Os/DSM/ 这个是引导的下载地址,不过下载后应该是不能安装成功的 PS. 最后出现的几个问题,记录: 选择镜像安装系统阶段,过了多个10分钟一直没有安装成功 需要把nas联网断开,可能是上传了镜像,但是仍然可能通过互联网下载某些安装包了,断开互联网,重启机器后重新选择安装速度正常 20240730 arpl 在github中拿掉了代码,并且没有更新了,但还是有一些小伙伴找到了最新资料的,试试根据下面文档升级到 7.2 版本吧 https://www.mspace.cc/archives/1002 -

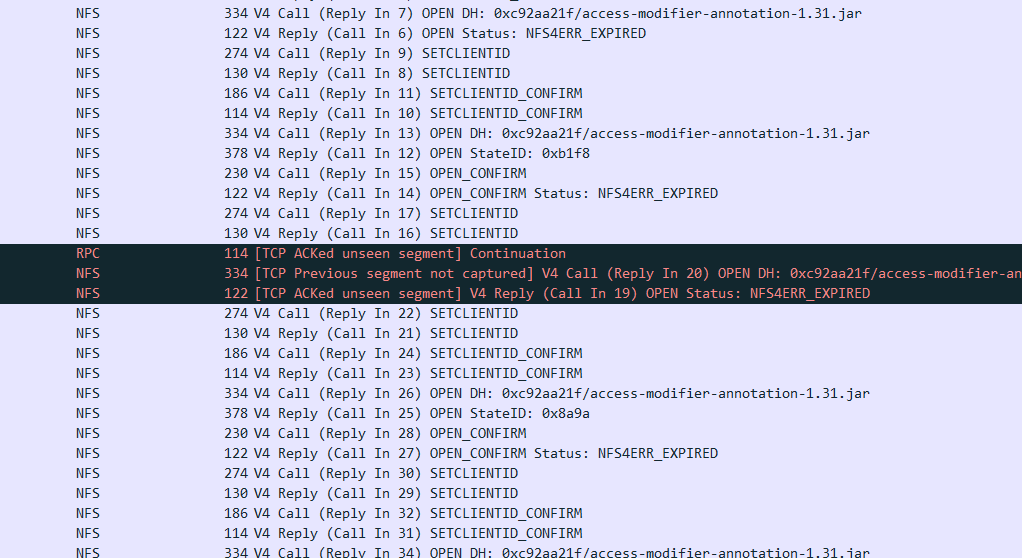

nfs优化与错误Lock reclaim failed、Input/output error 0x0 异常 挂载目录卡住,查看 /var/log/messages 有如下错误: NFS: nfs4_reclaim_open_state: Lock reclaim failed 0x1 参数优化 先说说系统参数优化: _netdev,vers=4.0,rw,noatime,nodiratime,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2,noresvport,proto=tcp 基本上挂载的时候跟直接使用这些参数即可,其中 vers=4.0 需要显示的写出来,centos7测试使用 vers=4 或者不写的情况下,使用 mount 可以观察得到版本为 4.1 ,所以为了使用 4.0 版本,一定要显示写 4.0 0x2 服务优化 如果并发较大的情况下,可以增大 nfs 的进程数,以提高并发 0x3 系统优化 linux对nfs客户端同时请求数进行了限制,可以用下面的命令查询,大部分机器默认是2,是比较小的。可以通过以下命令查询当前的数值: cat /proc/sys/sunrpc/tcp_slot_table_entries 内核编译的默认最大是2,可以增大设置成128,需要重新挂载nfs echo "options sunrpc tcp_slot_table_entries=128" >> /etc/modprobe.d/sunrpc.conf echo "options sunrpc tcp_max_slot_table_entries=128" >> /etc/modprobe.d/sunrpc.conf sysctl -w sunrpc.tcp_slot_table_entries=128 优化后重启机器,或者重新挂载nfs PS. 服务器 fstab 或者命令挂载实例: /etc/fstab 192.168.xx.xx:/aaa/bbb /opt/bbb nfs _netdev,vers=4.0,rw,noatime,nodiratime,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2,noresvport,proto=tcp 0 0 mount mount -t nfs -o _netdev,vers=4.0,rw,noatime,nodiratime,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2,noresvport,proto=tcp 192.168.xx.xx:/mnt/dev1/aaa /tmp/aaa 2023.12.07 补充更新 上面的内核参数以及挂载方法只是当时临时解决了问题,但是后来在其他机器上无法解决。所以并不是一个最终方案。试过了nfs3、nfs4.0、nfs4.1版本,更换过机器多种版本内核,仍然无法解决,可以参考抓包内容: 在挂载4.0版本的时候,ls文件卡住,包内容如下: 可以看到双方有非常多的设置 clientid、确认 的操作,这显然是不正常的 在挂载4.1版本的时候,ls文件很快,创建文件、读取文件、vi文件错误,但是创建目录可以 抓包内容(仅对vi做抓包、后续观察more是同样的问题): 可以看到有非常多的 NFS4ERR_EXPIRED 这明显也是不正常的,因为不管是链接还是会话,都不可能这么快过期,在一个 vi 或者 more 的时间过期多次 关于此错误代码的解释 13.1.5.3. NFS4ERR_EXPIRED (Error Code 10011) A stateid or clientid designates locking state of any type that has been revoked or released due to cancellation of the client's lease, either immediately upon lease expiration, or following a later request for a conflicting lock. 在后续的查阅资料中也基本没有相关的案例、或者没有解决办法。于是猜测是 openbds 的 nfs BUG 之类。但是业务太多,其他几个挂载点目前没问题,不好重启 nfs 服务。 基于我们场景的现状,小文件非常多,有大量web项目war包解压出来的,还有jenkins打包的代码文件,所以目前的想法是采用多个 nfs 服务来提供这些不同服务的挂载。首先是避免大量读写小文件到一个 nfs 中处理不过来,再就是出现问题的时候,其中某个nfs重启也不影响其他的。

nfs优化与错误Lock reclaim failed、Input/output error 0x0 异常 挂载目录卡住,查看 /var/log/messages 有如下错误: NFS: nfs4_reclaim_open_state: Lock reclaim failed 0x1 参数优化 先说说系统参数优化: _netdev,vers=4.0,rw,noatime,nodiratime,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2,noresvport,proto=tcp 基本上挂载的时候跟直接使用这些参数即可,其中 vers=4.0 需要显示的写出来,centos7测试使用 vers=4 或者不写的情况下,使用 mount 可以观察得到版本为 4.1 ,所以为了使用 4.0 版本,一定要显示写 4.0 0x2 服务优化 如果并发较大的情况下,可以增大 nfs 的进程数,以提高并发 0x3 系统优化 linux对nfs客户端同时请求数进行了限制,可以用下面的命令查询,大部分机器默认是2,是比较小的。可以通过以下命令查询当前的数值: cat /proc/sys/sunrpc/tcp_slot_table_entries 内核编译的默认最大是2,可以增大设置成128,需要重新挂载nfs echo "options sunrpc tcp_slot_table_entries=128" >> /etc/modprobe.d/sunrpc.conf echo "options sunrpc tcp_max_slot_table_entries=128" >> /etc/modprobe.d/sunrpc.conf sysctl -w sunrpc.tcp_slot_table_entries=128 优化后重启机器,或者重新挂载nfs PS. 服务器 fstab 或者命令挂载实例: /etc/fstab 192.168.xx.xx:/aaa/bbb /opt/bbb nfs _netdev,vers=4.0,rw,noatime,nodiratime,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2,noresvport,proto=tcp 0 0 mount mount -t nfs -o _netdev,vers=4.0,rw,noatime,nodiratime,rsize=1048576,wsize=1048576,hard,timeo=600,retrans=2,noresvport,proto=tcp 192.168.xx.xx:/mnt/dev1/aaa /tmp/aaa 2023.12.07 补充更新 上面的内核参数以及挂载方法只是当时临时解决了问题,但是后来在其他机器上无法解决。所以并不是一个最终方案。试过了nfs3、nfs4.0、nfs4.1版本,更换过机器多种版本内核,仍然无法解决,可以参考抓包内容: 在挂载4.0版本的时候,ls文件卡住,包内容如下: 可以看到双方有非常多的设置 clientid、确认 的操作,这显然是不正常的 在挂载4.1版本的时候,ls文件很快,创建文件、读取文件、vi文件错误,但是创建目录可以 抓包内容(仅对vi做抓包、后续观察more是同样的问题): 可以看到有非常多的 NFS4ERR_EXPIRED 这明显也是不正常的,因为不管是链接还是会话,都不可能这么快过期,在一个 vi 或者 more 的时间过期多次 关于此错误代码的解释 13.1.5.3. NFS4ERR_EXPIRED (Error Code 10011) A stateid or clientid designates locking state of any type that has been revoked or released due to cancellation of the client's lease, either immediately upon lease expiration, or following a later request for a conflicting lock. 在后续的查阅资料中也基本没有相关的案例、或者没有解决办法。于是猜测是 openbds 的 nfs BUG 之类。但是业务太多,其他几个挂载点目前没问题,不好重启 nfs 服务。 基于我们场景的现状,小文件非常多,有大量web项目war包解压出来的,还有jenkins打包的代码文件,所以目前的想法是采用多个 nfs 服务来提供这些不同服务的挂载。首先是避免大量读写小文件到一个 nfs 中处理不过来,再就是出现问题的时候,其中某个nfs重启也不影响其他的。 -

truenas更换损坏、故障的存储池硬盘 0x1 参考文档: https://www.truenas.com/docs/core/coretutorials/storage/disks/diskreplace/ 磁盘、存储池故障的日志参考: 现象1 New alerts: * Device /dev/gptid/e1fd123b-8795-11ed-bee4-b083fedec519 is causing slow I/O on pool dev1. 现象2 New alerts: * Pool dev1 state is ONLINE: One or more devices has experienced an unrecoverable error. An attempt was made to correct the error. Applications are unaffected. 现象3 New alert: * Pool dev1 state is DEGRADED: One or more devices are faulted in response to persistent errors. Sufficient replicas exist for the pool to continue functioning in a degraded state. The following devices are not healthy: * Disk IBM-XIV HUS723020ALS64A4 YFHEUB3G is FAULTED * Device: /dev/da6, failed to read SMART values. * Device: /dev/da6, Read SMART Self-Test Log Failed. 在现象1中提示io缓慢的时候如何定位是哪个磁盘呢?先可以通过命令查看每个盘的情况 root@freenas[/dev/gptid]# zpool status pool: boot-pool state: ONLINE scan: scrub repaired 0B in 00:24:37 with 0 errors on Sat Jul 29 04:09:37 2023 config: NAME STATE READ WRITE CKSUM boot-pool ONLINE 0 0 0 mirror-0 ONLINE 0 0 0 da13p2 ONLINE 0 0 0 da12p2 ONLINE 0 0 0 errors: No known data errors pool: dev1 state: DEGRADED status: One or more devices are faulted in response to persistent errors. Sufficient replicas exist for the pool to continue functioning in a degraded state. action: Replace the faulted device, or use 'zpool clear' to mark the device repaired. scan: scrub repaired 0B in 11:48:41 with 0 errors on Sun Jul 30 11:48:42 2023 config: NAME STATE READ WRITE CKSUM dev1 DEGRADED 0 0 0 raidz3-0 DEGRADED 0 0 0 gptid/15954610-bc06-11ed-a407-b083fedec519 ONLINE 0 0 0 gptid/e1b6b74b-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/e1fd123b-8795-11ed-bee4-b083fedec519 FAULTED 12 11 0 too many errors gptid/bb486a3d-c7d5-11ed-a407-b083fedec519 ONLINE 0 0 0 gptid/e249a2c9-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/034b850b-bc17-11ed-a407-b083fedec519 ONLINE 0 0 0 gptid/e1e4d7ce-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/e23f6124-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/e2971a19-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/e25d107c-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 errors: No known data errors 可以使用如下命令查看 gptid 对应的分区: label status | tail -n +2 | sort -k53 接着会看到有的盘会有多个分区,那么每个分区分别是什么呢,可以使用如下命令查询: gpart show

truenas更换损坏、故障的存储池硬盘 0x1 参考文档: https://www.truenas.com/docs/core/coretutorials/storage/disks/diskreplace/ 磁盘、存储池故障的日志参考: 现象1 New alerts: * Device /dev/gptid/e1fd123b-8795-11ed-bee4-b083fedec519 is causing slow I/O on pool dev1. 现象2 New alerts: * Pool dev1 state is ONLINE: One or more devices has experienced an unrecoverable error. An attempt was made to correct the error. Applications are unaffected. 现象3 New alert: * Pool dev1 state is DEGRADED: One or more devices are faulted in response to persistent errors. Sufficient replicas exist for the pool to continue functioning in a degraded state. The following devices are not healthy: * Disk IBM-XIV HUS723020ALS64A4 YFHEUB3G is FAULTED * Device: /dev/da6, failed to read SMART values. * Device: /dev/da6, Read SMART Self-Test Log Failed. 在现象1中提示io缓慢的时候如何定位是哪个磁盘呢?先可以通过命令查看每个盘的情况 root@freenas[/dev/gptid]# zpool status pool: boot-pool state: ONLINE scan: scrub repaired 0B in 00:24:37 with 0 errors on Sat Jul 29 04:09:37 2023 config: NAME STATE READ WRITE CKSUM boot-pool ONLINE 0 0 0 mirror-0 ONLINE 0 0 0 da13p2 ONLINE 0 0 0 da12p2 ONLINE 0 0 0 errors: No known data errors pool: dev1 state: DEGRADED status: One or more devices are faulted in response to persistent errors. Sufficient replicas exist for the pool to continue functioning in a degraded state. action: Replace the faulted device, or use 'zpool clear' to mark the device repaired. scan: scrub repaired 0B in 11:48:41 with 0 errors on Sun Jul 30 11:48:42 2023 config: NAME STATE READ WRITE CKSUM dev1 DEGRADED 0 0 0 raidz3-0 DEGRADED 0 0 0 gptid/15954610-bc06-11ed-a407-b083fedec519 ONLINE 0 0 0 gptid/e1b6b74b-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/e1fd123b-8795-11ed-bee4-b083fedec519 FAULTED 12 11 0 too many errors gptid/bb486a3d-c7d5-11ed-a407-b083fedec519 ONLINE 0 0 0 gptid/e249a2c9-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/034b850b-bc17-11ed-a407-b083fedec519 ONLINE 0 0 0 gptid/e1e4d7ce-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/e23f6124-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/e2971a19-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 gptid/e25d107c-8795-11ed-bee4-b083fedec519 ONLINE 0 0 0 errors: No known data errors 可以使用如下命令查看 gptid 对应的分区: label status | tail -n +2 | sort -k53 接着会看到有的盘会有多个分区,那么每个分区分别是什么呢,可以使用如下命令查询: gpart show -

zabbix主动模式和被动模式配置 0x0 配置区别 被动模式 agent 配置参考如下: LogFile=/tmp/zabbix_agentd.log Server=192.168.3.xxx ServerActive=192.168.3.xxx Hostname=192.168.10.xxx Timeout=30 配置比较简单,其中 ServerActive 应该是可以不用设置的,再就是 Timeout 参数官方推荐是不能太大的,因为被动模式下,所有数据由服务端获取,而拉取数据的线程是有限的,那么超时时间太大可能会影响所有机器的数据获取,但是如果设置太小,可能会出现自定义脚本运行时间太长,而服务端已经等待超时 被动模式 web 配置参考如下: 在 web 上选择添加机器,接口部分填入正确的 agent ip和端口,之后选择模板即可 主动模式 agent 配置参考如下: LogFile=/tmp/zabbix_agentd.log StartAgents=0 Server=xxx ServerActive=xxx:10055 Hostname=xxx Timeout=30 主动模式设置 StartAgents 为 0 ,表示关闭被动模式,然后设置 ServerActive 的ip或者主机名,如果服务端端口不是默认的10051,那么需要带上端口号 主动模式 web 配置参考如下: 在 web 上添加机器,接口部分可以随意填,主机名一定要跟 agent 中配置文件对应,再就是模板选择带 active 的

zabbix主动模式和被动模式配置 0x0 配置区别 被动模式 agent 配置参考如下: LogFile=/tmp/zabbix_agentd.log Server=192.168.3.xxx ServerActive=192.168.3.xxx Hostname=192.168.10.xxx Timeout=30 配置比较简单,其中 ServerActive 应该是可以不用设置的,再就是 Timeout 参数官方推荐是不能太大的,因为被动模式下,所有数据由服务端获取,而拉取数据的线程是有限的,那么超时时间太大可能会影响所有机器的数据获取,但是如果设置太小,可能会出现自定义脚本运行时间太长,而服务端已经等待超时 被动模式 web 配置参考如下: 在 web 上选择添加机器,接口部分填入正确的 agent ip和端口,之后选择模板即可 主动模式 agent 配置参考如下: LogFile=/tmp/zabbix_agentd.log StartAgents=0 Server=xxx ServerActive=xxx:10055 Hostname=xxx Timeout=30 主动模式设置 StartAgents 为 0 ,表示关闭被动模式,然后设置 ServerActive 的ip或者主机名,如果服务端端口不是默认的10051,那么需要带上端口号 主动模式 web 配置参考如下: 在 web 上添加机器,接口部分可以随意填,主机名一定要跟 agent 中配置文件对应,再就是模板选择带 active 的